by 太田 亮三

マイクロソフトは、生成AIにおいて、大規模言語モデルと同等機能でありながら、よりサイズが小さい小規模言語モデル(SLM)を開発し、「Phi-3」ファミリーとして公開した。

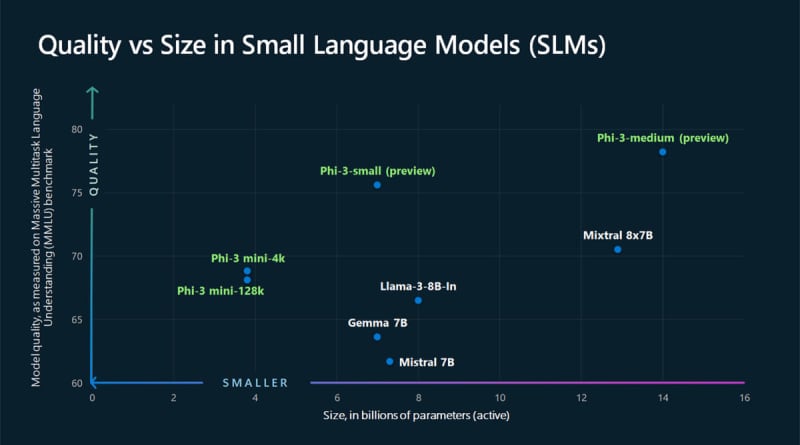

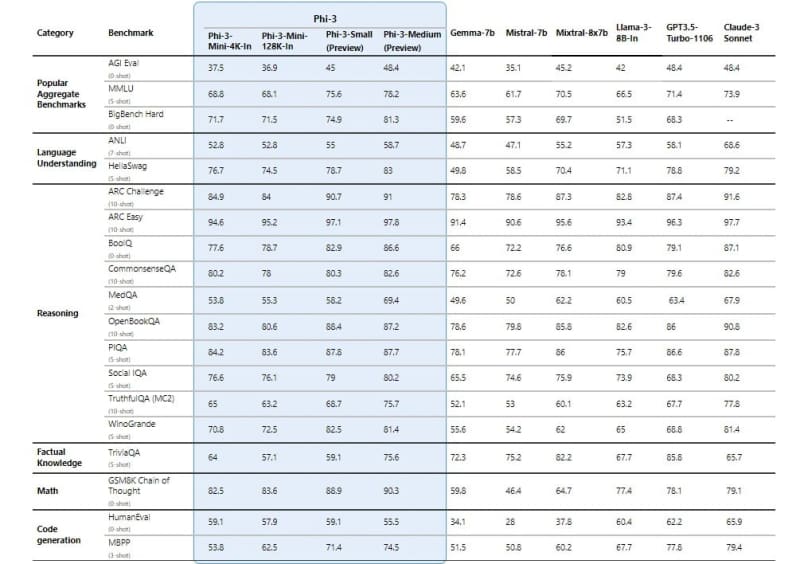

「Phi-3」は、最も高性能でコスト効率が高いと謳う小型言語モデル。「Phi-3」ファミリーはオープンモデルとして公開される。マイクロソフトの研究者によって開発された学習のイノベーションを反映させたことで、言語、コーディング、数学の能力を評価するさまざまなベンチマークにおいて、同等やそれ以上のサイズのモデルを上回るという。

現在公開されている第1弾は、38億パラメータの「Phi-3-mini」で、2倍のパラメータサイズのモデルよりも優れた性能を発揮するとしている。

「Phi-3」ファミリーは今後、70億パラメータの「Phi-3-small」、140億パラメータの「Phi-3-medium」がラインナップされる予定で、Azure AI Model Catalogなどのモデル運用基盤で利用可能になる。

Phi-3-mini は、「Microsoft Azure AI Model Catalog」で提供が開始されている。また「Hugging Face」や、ローカルマシン上でモデルを実行するための軽量フレームワーク「Ollama」で利用できるようになる。このほか「NVIDIA NIM」マイクロサービスとしても利用可能になり、通常のAPIインターフェースで、どこでもデプロイが可能になる。

「Phi-3 ファミリー」の追加モデルは近日中に発表される予定で、マイクロソフトでは、品質とコストの両面でより多くの選択肢を提供するとしている。

同社では、AIの利用動向において、あまり複雑ではないタスクを小型モデルに担わせる企業が出てくると予想。SLM(小規模言語モデル)はLLM(大規模言語モデル)に代わるものではなく、クラウドで処理するほどではないタスクを担うために、独自の立ち位置を形成するとしている。