by 関根 慎一

米Microsoftは23日(現地時間)、小規模言語モデル(SLM)「Phi-3」を発表した。23日時点ではPhi-3ファミリーとして複数あるモデルのうち最も小規模な「Phi-3-mini」がHagging Face、Ollama、NVIDIA NIMで利用可能になった。

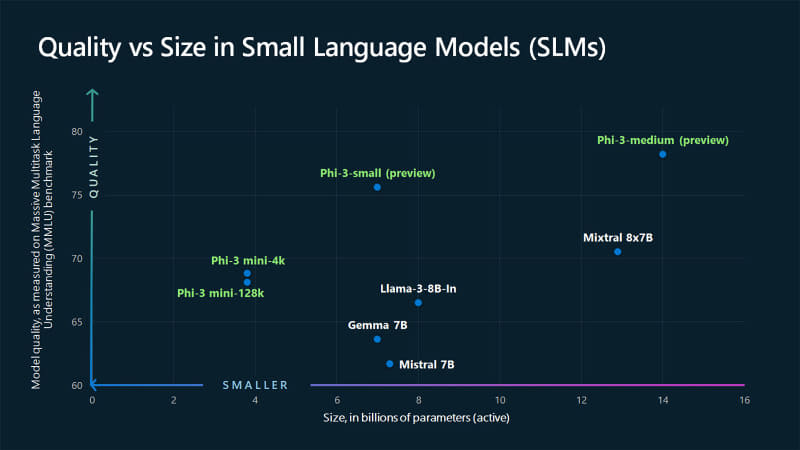

Phi-3-miniは人々の日常的なコミュニケーション方法をベースとし、さまざまな指示に従うよう訓練されたオープンモデルで、トレーニングデータは38億パラメータ。コンテキスト長は4Kトークンと128Kトークンを用意。言語、推論、コーディング、数学のベンチマークで、同サイズのLLM(大規模言語モデル)よりも高い性能を発揮できるとしている。

Phi-3ファミリーに関しては、今後数週間以内に70億パラメータの「Phi-3-small」と140億パラメータの「Phi-3-medium」の提供も開始する予定。

MicrosoftはSLMについて品質とコストのバランスを重視する方向性を採っており、サイズが小さく返答(レイテンシ)が速いSLMは、特にタスクの複雑性が低く高速な返答が必要となる用途や、オフライン端末などリソースが制限された環境での利用に向くという。具体例としてはこのほか車載コンピュータ、交通管理システム、工場内のスマートセンサー、監視カメラなどを挙げている。