by 笠原一輝

トヨタグループ向けにAIやソフトウエア基盤を開発しているウーブン・バイ・トヨタ

ウーブン・バイ・トヨタは、トヨタ自動車グループのソフトウエア開発企業。その前身となっているのは2018年にトヨタ、デンソー、アイシンの3社が出資して設立されたTRI-AD(トヨタ・リサーチ・インスティテュート・アドバンスト・デベロップメント)で、2023年に現在の社名となるウーブン・バイ・トヨタに変更され、トヨタ自動車の100%子会社となって今に至っている。

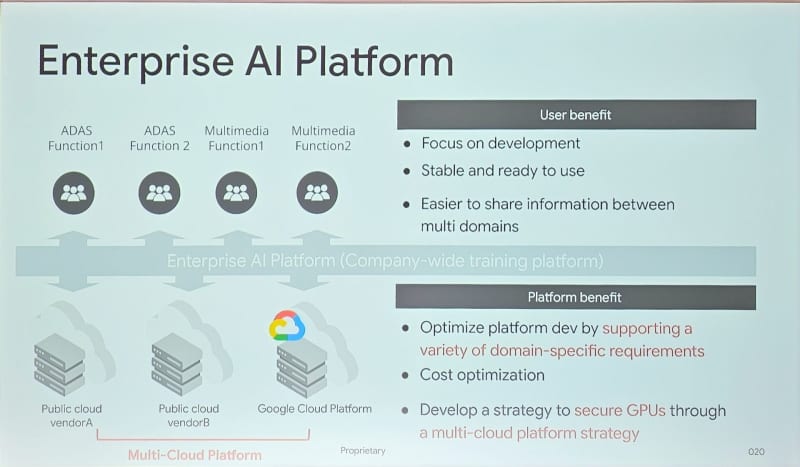

そのウーブン・バイ・トヨタは4月上旬に米国ラスベガスで行なわれたクラウドサービスプロバイダー(CSP)Google Cloudの年次イベント「Google Cloud Next '24」に参加し、同社のAI開発環境に関する説明を行なった。ウーブン・バイ・トヨタ エンタープライズテクノロジー エンタープライズAI部門責任者 谷内出悠介氏は「ウーブン・バイ・トヨタでは、トヨタ自動車グループのさまざまなAI開発を担っており、そのためマシンラーニングのワークロードが膨大になっており、演算リソースとしてのGPUが足りないという状況になっている。従来は1つのCSPを活用していたのだが、安定してGPUを確保するという観点からマルチクラウドに舵を切ることになり、Google Cloudとの話を始めた」と、ウーブン・バイ・トヨタがGoogle Cloudを活用することになった経緯について説明した。

ウーブン・バイ・トヨタは、車両向けソフトウエアプラットフォーム「Arene OS」、AD(自動運転)/ADAS(先進運転支援システム)、モビリティのためのテストコースであり実証実験の街Woven Cityなどの開発を事業内容としており、トヨタ自動車グループ向けのさまざまなソフトウエア開発の一翼を担っている。「今後自動車はSDVの時代を迎えると言われているが、われわれエンジニアとしてはそうした時代を迎えてもトヨタグループが十分に対応できる、そうした基盤を開発しているという心意気で開発している」(谷内出氏)との言葉の通りで、ウーブン・バイ・トヨタの役割はトヨタ自動車本体やそのグループ企業が必要とする、ソフトウエアを開発し、それを提供するということにある。

ウーブン・バイ・トヨタが開発しているArene OSはその代表的な例。現在の自動車はハードウエアをすりあわせて作るという開発手法が一般的だが、今後は1つないしは複数の汎用プロセッサーにソフトウエアを組み合わせとなる「SDV(Software Defined Vehicle)」と呼ばれるソフトウエア定義の自動車に移行する時代が来ると考えられている。

そうした時代に向けて、自動車メーカーはその基礎となるようなOSを開発することが次の競争軸になると考えられている。そうした動向はトヨタグループだけでなく、トヨタとグローバルに1位、2位を争っているフォルクスワーゲン・グループもグループ企業のCARIADが同じようにOS(VW.os)を開発していることはよく知られている。

今後自動車メーカーにとって、ソフトウエア開発がこれまで以上に重要になっていくことは明らかだし、それに加えてその開発期間や開発コストも他メーカーとの競争上重要で、高効率にソフトウエアの開発を行なっていくことが重要になりつつあるのだ。

ウーブン・バイ・トヨタの開発はクラウドベースでスタートし、GPU不足の影響でマルチクラウドへ舵を切る

ウーブン・バイ・トヨタは、2018年に設立された比較的新しい企業であることもあり、レガシー(過去の遺産)と呼ばれる古いIT資産を抱えておらず、最初から比較的新しいITとなるクラウドを活用したITのシステムを構築してきた。

谷内出氏によれば、従来ウーブン・バイ・トヨタは、別のCSPが提供するクラウドをメインに活用しており、Google Cloudは大規模には利用してこなかったという。今回なぜGoogle Cloudの利用を開始するなど、マルチクラウド(複数のCSPを利用してシステムを構築すること)へ舵を切ったのだろうか? 谷内出氏によれば、車載AIの開発に欠かせない、GPUの需要逼迫がその背景の1つになっているという。

今後自動運転やADASなどに採用される車載AIの開発で、最も大きなパートを占めるのが、「学習」(英語で言うとTraining)と呼ばれる開発段階になる。学習とは、簡単に言うとプログラマーが作成したAIのモデル(AIのアルゴリズムを実装したもの)に読み込ませて、AIを鍛えていく段階になる。人間の子どもに動物やその写真を見せてネコをネコ、ライオンをライオンと教えていく幼児学習があると思うが、AIの学習もそれと同じようなものだと考えると分かりやすい。AIのモデルにさまざまなデータを読み込ませて、AIを子どもから大人へ成長させる、そうした作業だ。

人間の学習はよりアナログだが、AIの学習はデジタルで、より多くのデータをAIに読み込ませることで、AIを使えるものにすることが可能になる。このため、AIの精度や正確性などは、(例外はあるが)読み込ませたデータ量に比例することになるので、AIの開発をしている開発者はより多くのデータをAIに読み込ませたいと考えている。この読み込みの速度を決定するのが、その学習にどんな性能のプロセッサーを利用するかだ。現在それにもっとも適して高速に処理できるのが、NVIDIAが提供するGPU(Graphics Processing Unit)だと考えられており、現在世界的にGPUの需要が高まり、供給が逼迫する状況になっている。

このためCSPが提供するGPUを利用するサービスもだいぶ先まで予約がいっぱいという状況になっており、申し込んでも思うように利用できないという状況が発生しているのだ。このため、ウーブン・バイ・トヨタのように、大量のGPUを利用したいユーザーにとって、確実にGPUを利用できるようにするために、マルチクラウドと呼ばれる複数のCSPを同時並行的に利用する動きが顕著になっているのだ。

Google Cloudが昨年発表した新しいクラウドストレージを活用してランニングコストを50%削減

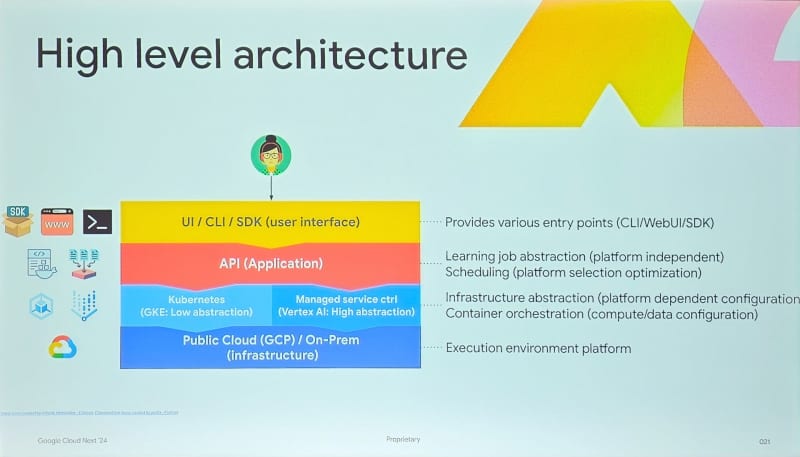

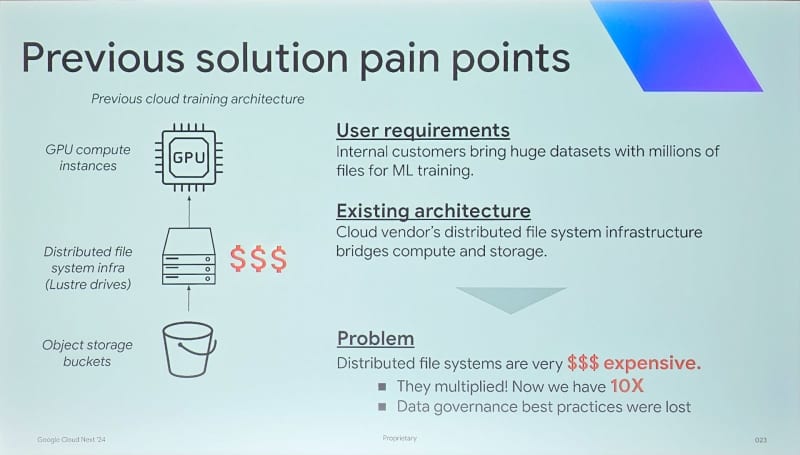

ウーブン・バイ・トヨタの谷内出氏によれば、マルチクラウドにするにあたり実際にはいくつかの点で課題があったという。谷内出氏によれば、その最大の課題は、学習用のデータを置いておく場所になるストレージのコストと性能だったという。

AIの学習には膨大な量のデータが必要になる。例えば開発車両から上がってくる画像データ、動画データ、軌跡データなどさまざまなデータがクラウド上にあるストレージに保存され、それを利用してGPUで学習が行なわれる。その時に問題になるのが、どのようなストレージを利用してデータを置いておくかだ。

というのも、一口にストレージといっても、非常に容量あたりの価格が低価格なHDDを使っているのか、あるいは容量あたりの価格は高いが高性能なフラッシュメモリを利用しているのかで、性能も価格も違ってくるのは、読者の皆さまが使われているPCと何も変わらないからだ。CSPが提供するクラウドストレージも、同じように性能と価格に違いがあり、どのストレージを選ぶかで性能やコストが変わってくるからだ。ウーブン・バイ・トヨタのように、全トヨタグループのAI学習を行なうという規模で利用している場合には、性能を重視すればするほど、そのコストが膨大になってしまうのだ。

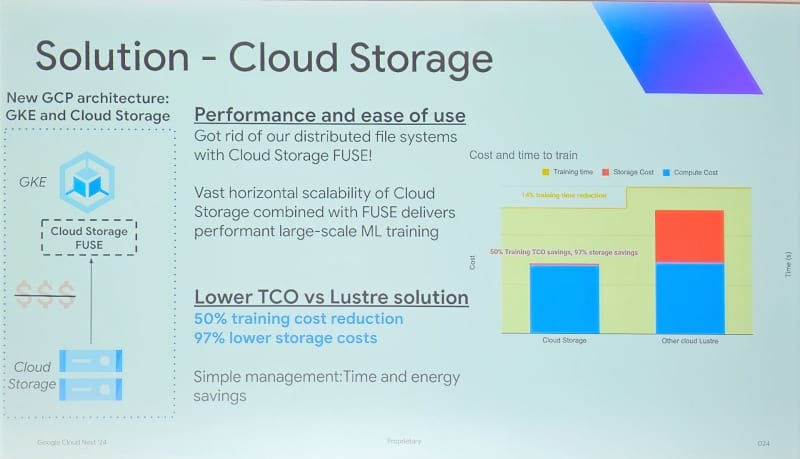

谷内出氏によれば、従来のCSPで利用していたクラウドのAI学習で一般的に利用されている「Lustre」というクラウドストレージを利用した場合、AI学習に適した性能を得ることはできるが、ストレージにかかるコストが増大してしまう傾向にあるという。そこで、Google CloudでもAI学習を行なうマルチクラウドの構成を行なう時にストレージを見直して、「Google Storage FUSE」というGoogle Cloudが昨年の8月末に発表した新しいストレージを利用することにしたのだという。

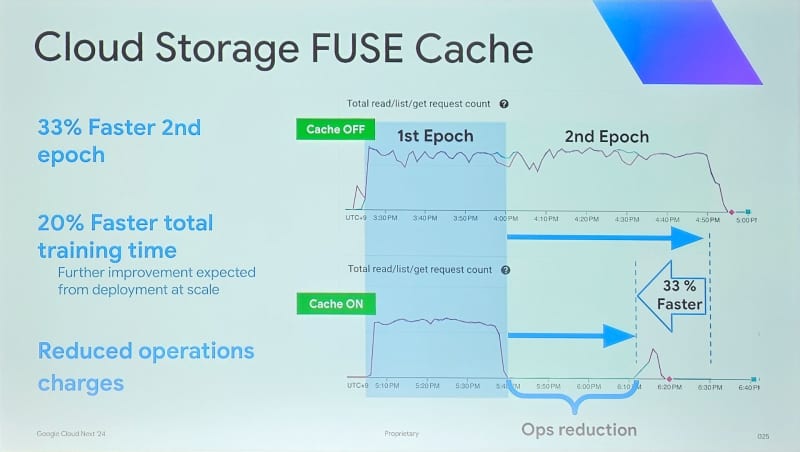

これまでのクラウドストレージを利用する場合、AI学習を行なうGPUの近くにある容量は小さいけれど高速なストレージに、データをコピーしてから学習を行なうということが一般的だったという。そうすると、そうしたデータのコピーを行なっている間、GPUは動作を停止しており、せっかく高いお金を払ってGPUを確保していてもそれが有効利用できていないことになる。それに対してGoogle Storage FUSEでは、GPUから直接アクセスしても十分な性能を実現しているため、いちいちGPUローカルにデータをコピーする必要がなく性能を低下させることなく、コストの削減を行なうことが可能になるのだ。

その結果は劇的で、「従来のクラウドストレージに比べてストレージのコストを97%削減し、ランニングコスト(IT業界ではランニングコストのことをTCOと呼ぶ)は50%削減できた」と谷内出氏は説明した。

すでに説明したように、ウーブン・バイ・トヨタはトヨタグループのAI開発の大きな部分を担っており、トヨタ本体だけでなく、ウーブン・バイ・トヨタのArene OSの開発などさまざまなAIの学習が行なわれているため、その規模は世界的に見てもかなりの大規模だと言える。その意味で、ランニングストが50%削減できることの意味は決して小さくないし、マルチクラウド化によりGPUの需要拡大に対して殉難に対応できるようになったことは、トヨタグループが他社とソフトウエア開発で競争していく上で大きな意味があると言えるだろう。