by 高橋 正和

米Red Hatは、年次イベント「Red Hat Summit 2024」を、5月6~9日(米国時間)にコロラド州デンバーとオンラインのハブリッドで開催した。

テーマは「Unlock what's next」。今回はAIのためのプラットフォームに関する新発表が多くなされた。

本記事では、Red Hat Summit 2024での新発表について、5月7日および8日の基調講演をもとにレポートする。

InstructLab:オープンソースの手法で生成AIモデルを開発

生成AIモデルをオープンソースの手法で開発する「InstructLab」プロジェクトが発表された。既存のLLM(大規模言語モデル)の基盤モデルを元に、コミュニティで再トレーニングするものだ。

IBMとRed Hatとで始めたプロジェクトで、InstructLabの名前もIBM Researchが発表したLAB(Large-scale Alignment for chatBots)という手法からとられている。

基盤モデルとしては複数のモデルに対応する。InstructLabには現時点で、IBMのGraniteの拡張版と、Llama 2から派生したLabradorite、Mistralから派生したMerliniteが用意されている。

InstructLabでは、オープンソースの手法により「knowledge(知識)」と「skills(スキル)」のコントリビューションを受ける。基調講演でのMatt Hicks氏(Red HatのCEO)の説明によると、knowledgeは辞書的なデータであり、skillsはknowledgeを組み合わせて何をするか、例えば“1+1=2”のようなものだという。

こうしたknowledgeとskillsを元に、学習のための大規模な合成データを生成し、アラインメント調整によるトレーニングを行う。

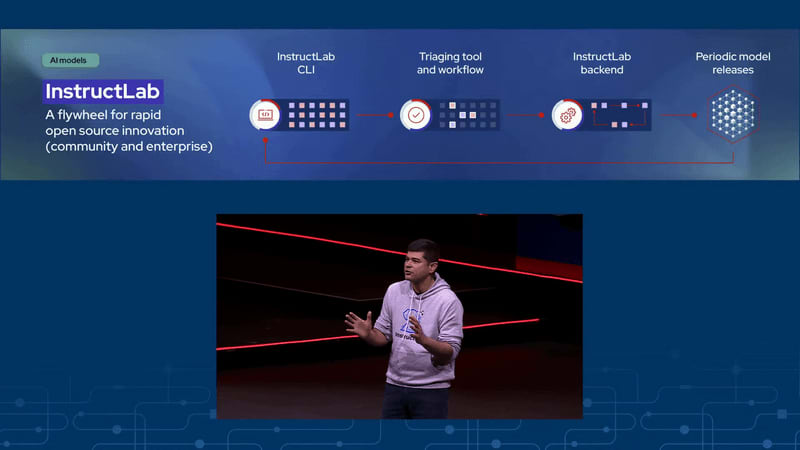

InstructLabはさらに、タクソノミー、コマンドラインツール、モデルトレーニングのインフラといったプロジェクトから構成される。

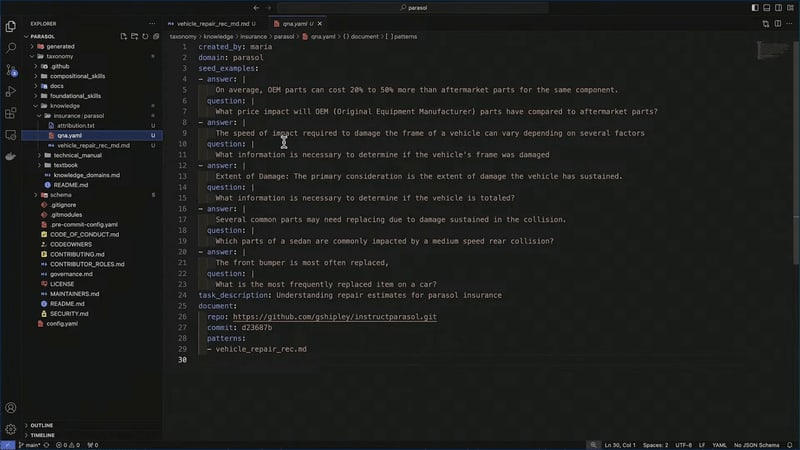

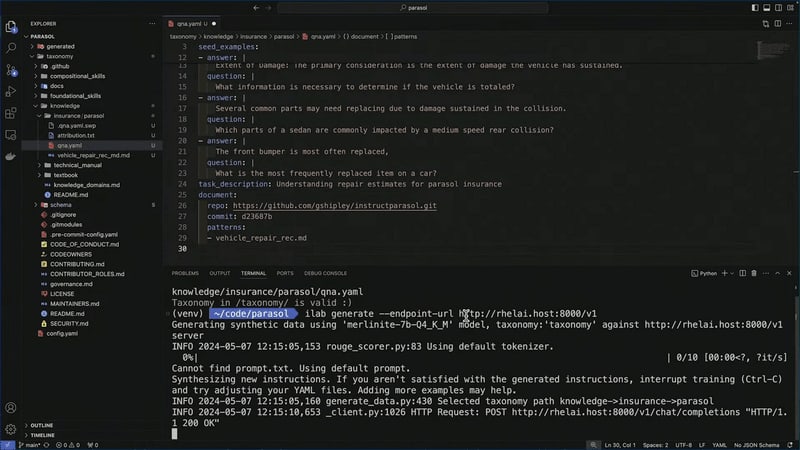

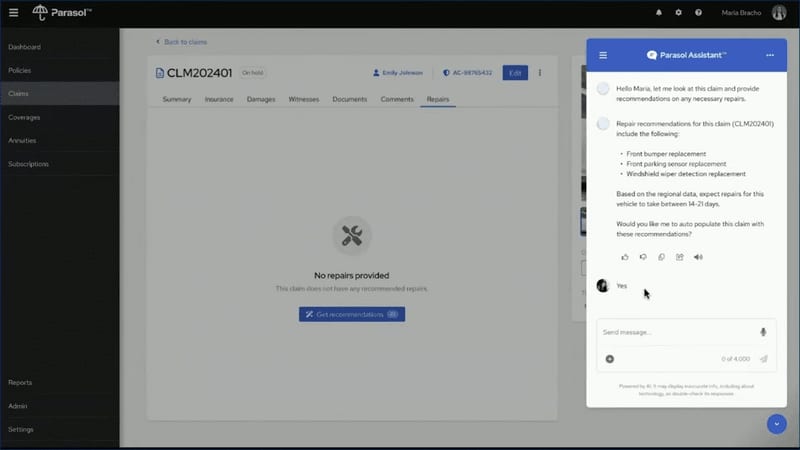

7日の基調講演ではInstructLabのツールがデモされた。架空の損害保険会社のチャットボット開発をテーマに、YAML形式の過去の応対事例をYAML形式で記述したファイルを元に、コマンドラインのilabコマンドを使ってデータを生成。そのデータをサーバーに送ってAIモデルのトレーニングを実行する例を見せていた。

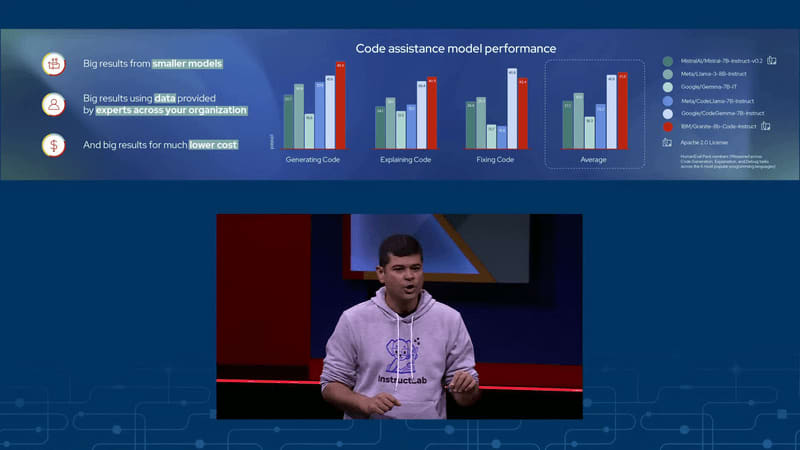

Granite:IBMの生成AIモデルをオープンソース化

InstructLabの発表に合わせて、IBM ResearchとRed Hatは、IBM Researchによる生成AIの基盤モデル「Granite」ファミリーのモデルを、Apache 2.0ライセンスでオープンソース化すると発表した。

なお、IBMのアナウンスでは「IBM Graniteのコードモデルの4バリエーションをオープンソースにする」と書かれているが、今回のMatt Hicks氏の基調講演やRed Hatのプレスリリースでは「言語モデルとコードモデル」とされている。

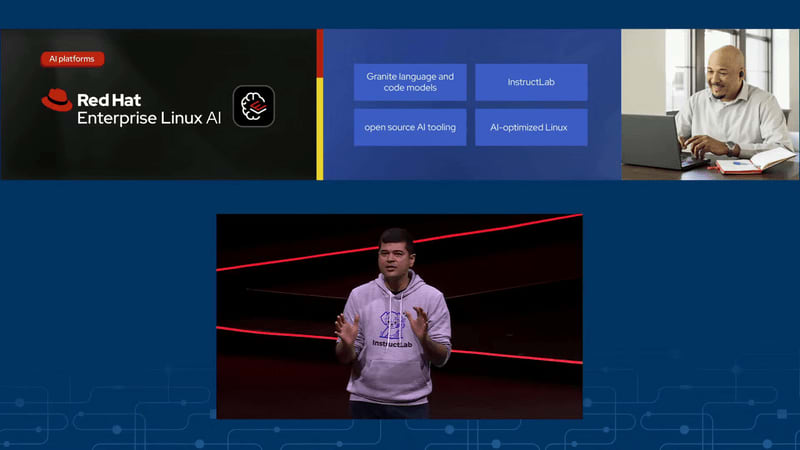

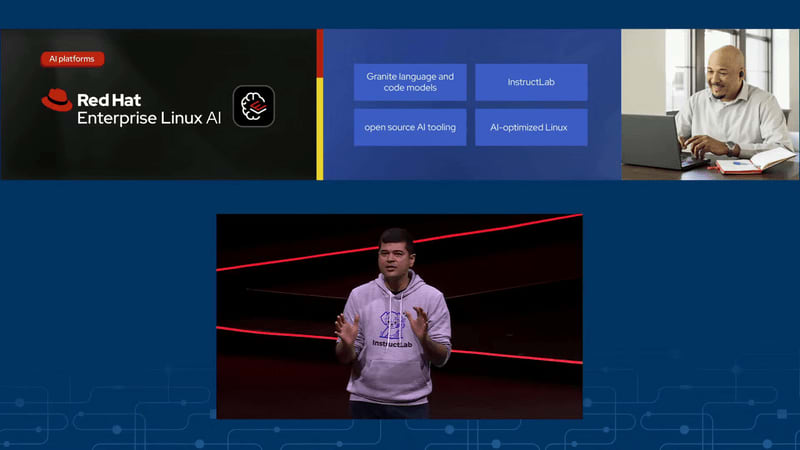

RHEL AI:GraniteモデルやInstructLabツールなどをRHELに搭載したOSイメージ

こうしたGraniteのAIモデルや、InstructLabのツール、後述するPodman AI LabなどをRed Hat Enterprise Linux(RHEL)に組み込んで最適化した「Red Hat Enterprise Linux AI(RHEL AI)」も発表された。RHLはもちろん、GraniteモデルやInstructLabツールについてもRed Hatのサポート付きとなっている。

次項で取り上げるRHELのイメージモードによる、ブータブルOSイメージとして提供される。現在、開発者プレビュー。

基調講演でRed HatのAshesh Badani氏(VP and Chief Product Officer)は、「主要なパートナーとともにRHEL AIに取り組んでいる」として、NVIDIA、Intel、Cisco、IBM Cloud、HPE、Dell Technologies、Lenovo、Supermicroのロゴを示した。

RHELのイメージモード:コンテナイメージからOSをインストール

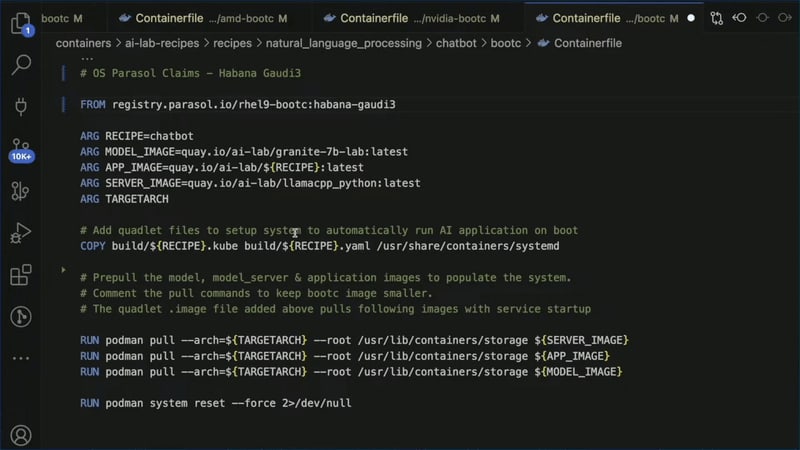

イメージモードは、コンテナイメージを元にOSをインストールする新しい仕組みだ。5月1日にリリースされた、「RHEL 9」の最新版「RHEL 9.4」でテクノロジープレビューとして含まれ、Red Hat Summitであらためてアナウンスされた。

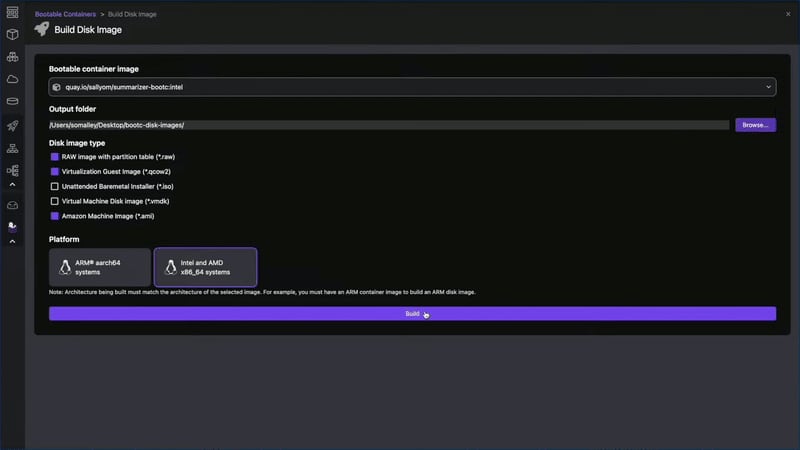

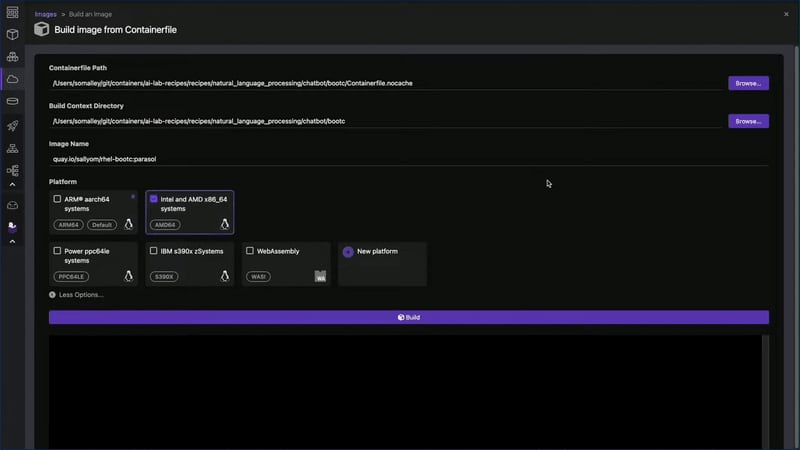

イメージモードでは、OCIコンテナ(Docker形式のコンテナ)の形式で、Linuxカーネルやsystemdなどが含まれた特殊なコンテナを作成する。このコンテナはRed Hat Quayなどのコンテナレジストリに登録でき、通常のコンテナと同様にデプロイ先から取得する。デプロイ先では、bootcというソフトウェアを使って、仮想マシンイメージやISOイメージを作成したり、システムをディスクにインストールしたりできる。

いわば、これまでのISOイメージや仮想マシンイメージなどからのRHELのインストールと、OCIコンテナによるアプリケーションのデプロイとをかけあわせたような方法だ。イメージモードにより、GitOpsなCI/CDなどのコンテナでのデプロイや、レイヤーによるシステムの更新などの手法を使って、システムのライフサイクル管理ができる。

また、Podman Desktop向けのbootc拡張機能を使って、Podman Desktopからさまざまなイメージモードの操作ができる。なお、PodmanはDocker対抗のソフトウェアであり、そこでPodman DesktopはDocker Desktopに相当するソフトウェアである。

基調講演では、前述のチャットボット開発をテーマにしたデモの続きで、できあがったアプリケーションからRHELイメージモードのコンテナイメージを作り、さらにそこから仮想マシンイメージを作ってデプロイするところを見せていた。

Podman AI Lab:AI開発のためのPodman Desktopの拡張機能

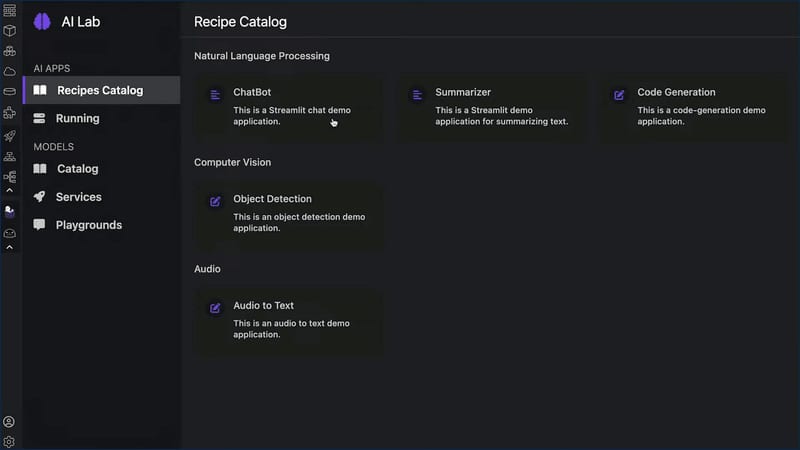

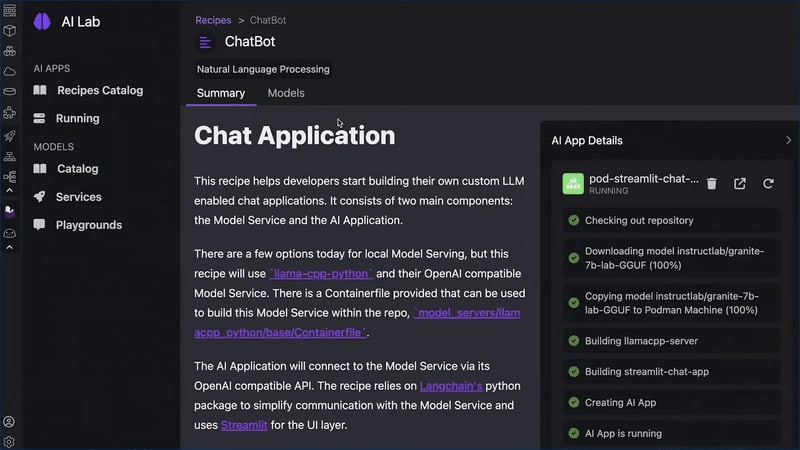

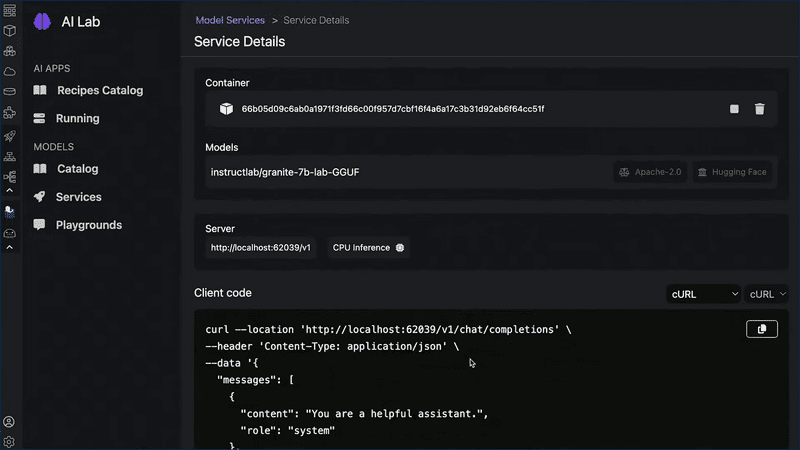

Podman AI Labは、Podman Desktopの拡張機能で、生成AIのアプリケーションを、コンテナを使って開発やテストするためのものだ。レシピカタログも備えているため、チャットボットなどの一般的なユースケースの開発が助けられる。

基調講演のチャットボット開発のデモでは、最初のところでPodman AI Labを使い、レシピカタログからチャットボットのひな型を選んで、プレイグラウンド環境で実行していた。

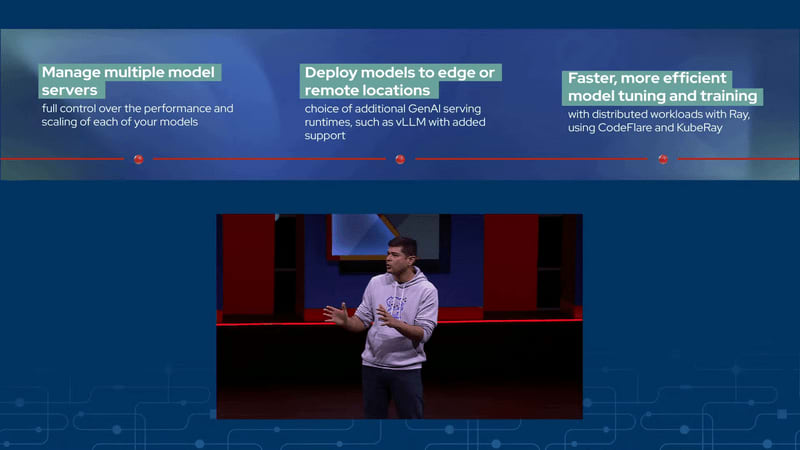

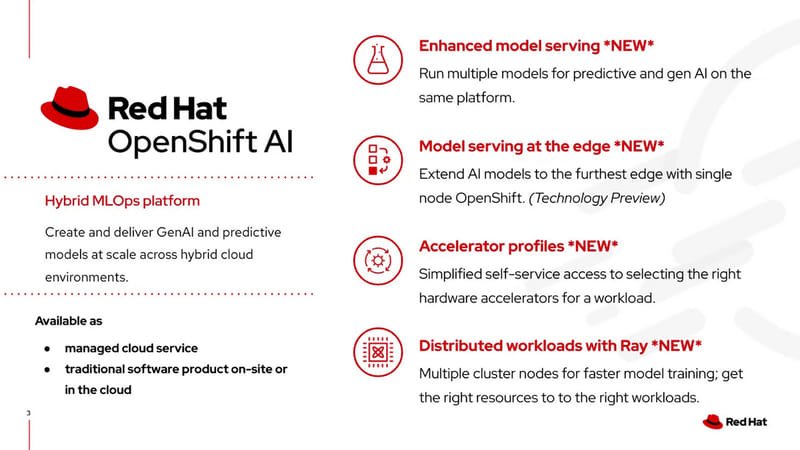

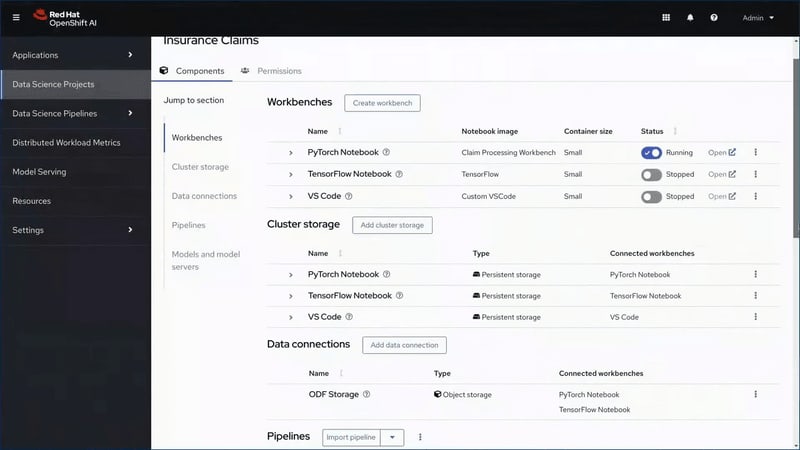

Red Hat OpenShift AIの強化:エッジ対応や、分散ワークロード、GPU割り当ての簡易化など

「OpenShift AI」は、OpenShift上のMLOpsのプラットフォームだ。複数のプロジェクトからなるもので、データサイエンティスト向けの機能である「OpenShift Data Science」に始まり、アプリケーションへのモデルのサービング(提供)などの機能を持っている。

今回発表された新機能としては、まず、「エッジへのモデルサービング」がある(テクノロジープレビュー)。エッジにシングルノードのOpenShiftを配置してAIモデルをデプロイする。

「モデルサービングの強化」としては、サービングにおいて予測AIと生成AIの両方をサポートする。これにより、複数のユースケースに対して単一プラットフォームで予測AIと生成AIを実行でき、コスト削減や運用の軽減につながるという。

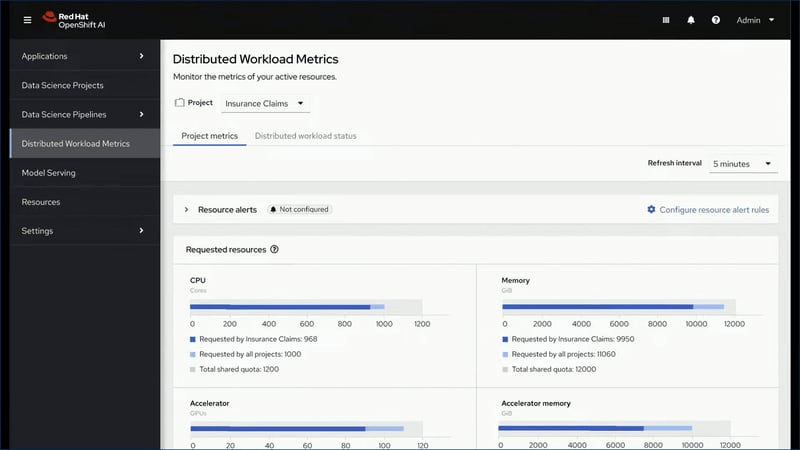

「Rayによる分散ワークロード」では、Pythonの分散処理フレームワーク「Ray」と、それをKubernetesで動かす「KubeRay」、その上の分散ワークロード機能「CodeFlare」に対応し、複数のクラスターノードを使ってデータ処理やモデルトレーニングを高速で効率的にする。

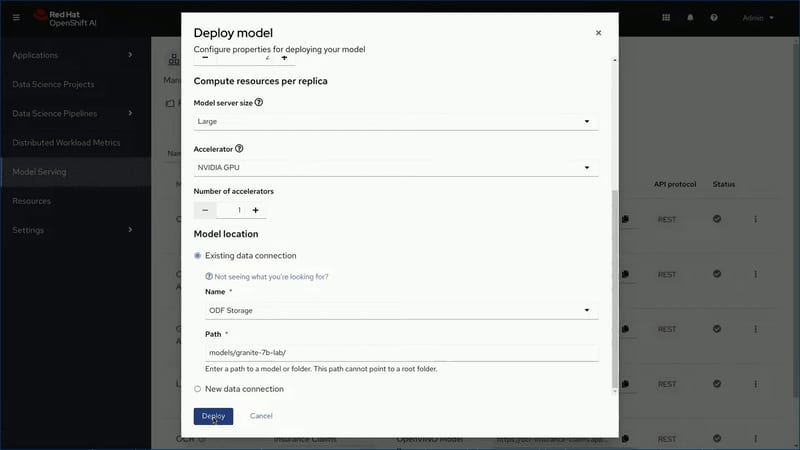

「アクセラレータープロファイル」では、管理者が多数で多様なハードウェアアクセラレーター(GPUなど)リソースをプロファイルで管理し、利用者がセルフサービスでモデル作成やモデルサービングなどのワークロードに合わせてリソースを利用できるようにする。

Red Hat Lightspeed:OpenShiftやRHELの管理に生成AIを

2023年5月のRed Hat Summitでは、構成管理ツール「Ansible」のプレイブック (構成情報ファイル)の作成を生成AIが助ける「Ansible Lightspeed」が発表され、11月に一般提供開始された。いわば、Ansible用のGitHub Copilotのようなものだ。

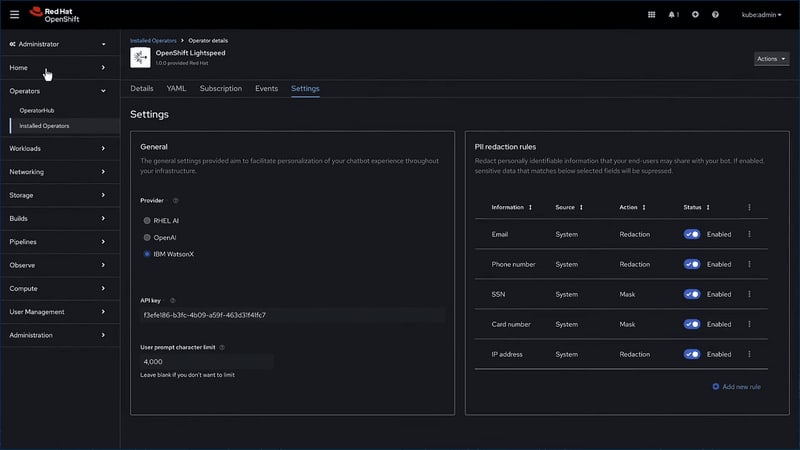

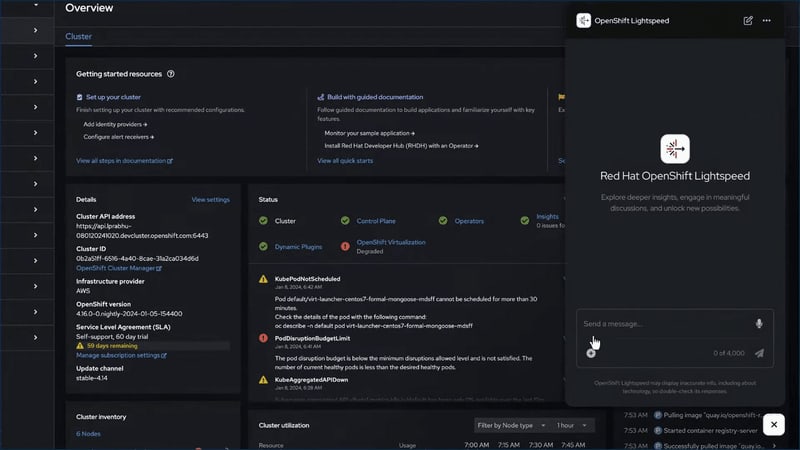

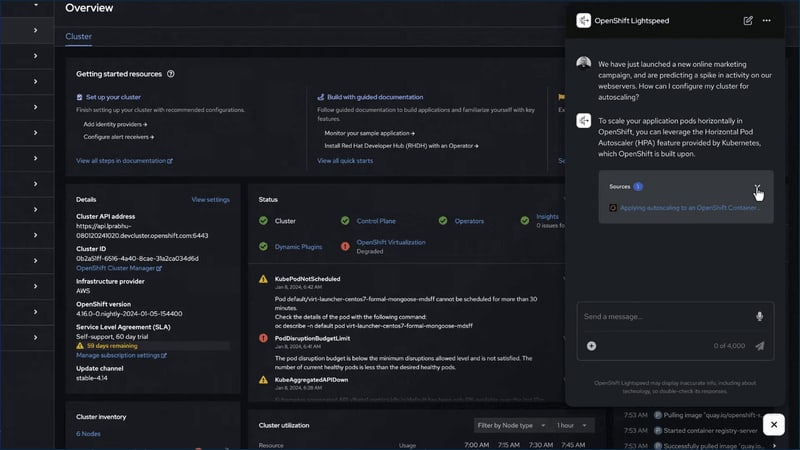

今回のRed Hat Summitでは、これをほかの分野にも広げる「Red Hat Lightspeed」というブランドが発表された。具体例としては、コンテナプラットフォームのRed Hat OpenShiftの管理に応用する「OpenShift Lightspeed」と、RHELの管理に応用する「Red Hat Enterprise Linux Lightspeed」が挙げられた。

OpenShift Lightspeedは、2024年後半に一般提供される予定。一方のRed Hat Enterprise Linux Lightspeedは、まだ計画段階だという。

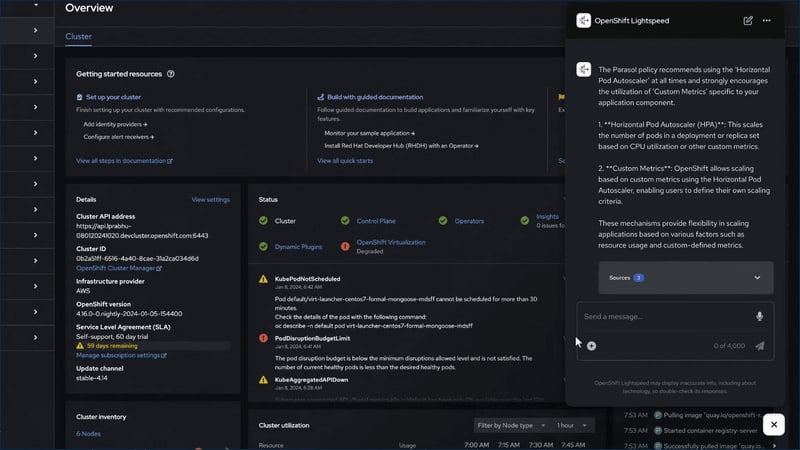

8日の基調講演では、OpenShift Lightspeedがデモされた。OpenShiftの管理画面の一角に表示されるOpenShift Lightspeedのボタンをクリックすると、チャットダイアログが開く。ここでOpenShiftの運用について質問をして、回答が得られるところ、さらにはAIプロバイダーを切り替えられるところ見せていた。

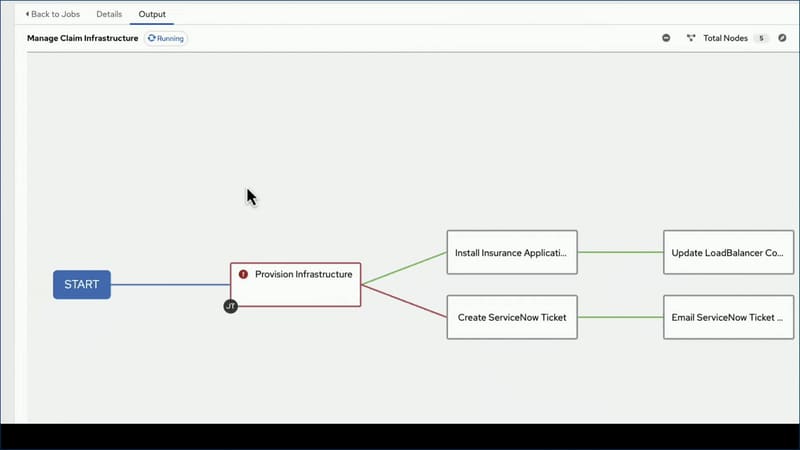

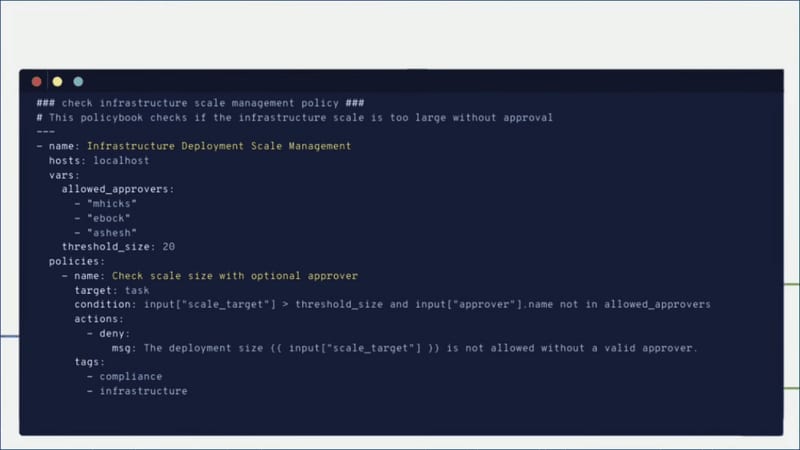

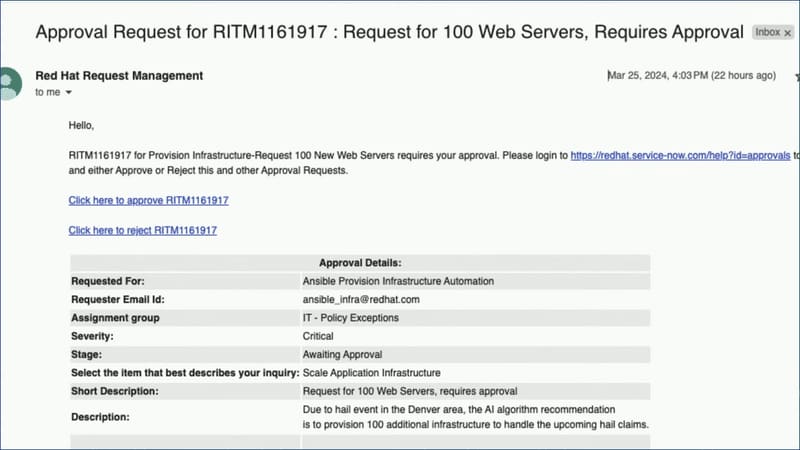

Ansible Policy as Code:ポリシー適用を自動化して強制する

Ansibleの将来の機能として、「Policy as Code」がアナウンスされた。ガバナンス、リスク、コンプライアンス(GRC)のポリシーを、Ansibleのコードの形で記述することで、基準を自動的に強制する。これにより、オンプレミスからクラウド、エッジまでのハイブリッドマルチクラウド環境の全体に、ポリシーを行き渡らせられるという。

Red Hatでは、特にAIに関する複雑なガバナンスやコンプライアンスの自動的に適用して一貫性をもたらすことができるとしている。

8日の基調講演では、7日に続いて架空の損害保険会社を想定したデモが披露された。デモでは、キャパシティのためにWebサーバーを増やすところで、ポリシー違反で失敗した。このポリシー設定では、20台を超えるときに、設定した3人の承認を得られていないと、実行が拒否されることになっている。これによりServiceNowのチケットが発行され、メッセージから承認を実行すると、Webサーバーを増やすのに成功した。